MapReduce是一種用于大規模數據處理的編程模型,它將任務分為兩個階段:Map和Reduce。在Map階段,輸入數據被分割成多個片段,每個片段由一個Map任務處理。在Reduce階段,所有Map任務的輸出被合并成一個最終結果。

MapReduce是一種編程模型,用于處理和生成大數據集,它由兩個主要步驟組成:Map(映射)和Reduce(歸約),以下是關于MapReduce源碼的一些咨詢信息:

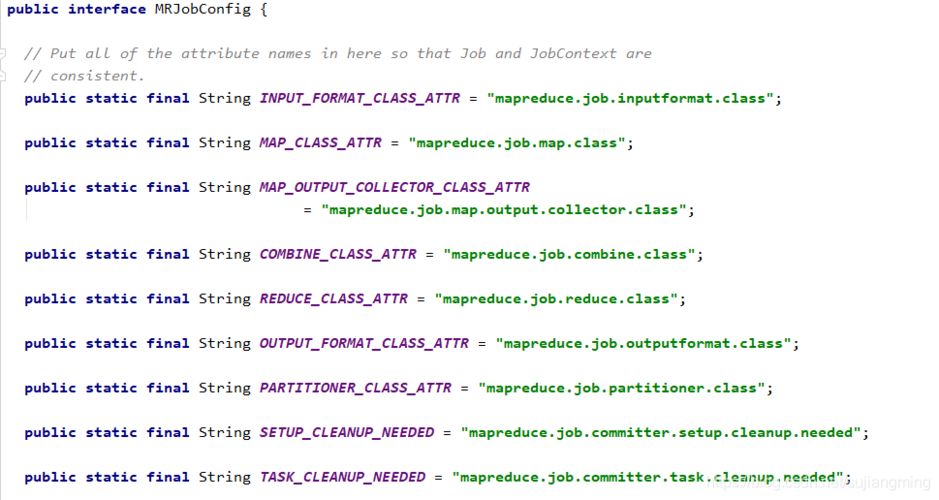

1. MapReduce框架的組成部分

Mapper: 負責處理輸入數據并產生中間鍵值對。

Shuffle: 將Mapper輸出的中間鍵值對按照鍵進行排序和分組。

Reducer: 接收來自Shuffle階段的分組鍵值對,并對每個鍵執行歸約操作。

2. MapReduce源碼的主要文件

| 文件名 | 描述 |

mapredsite.xml |

MapReduce配置文件,包含各種配置選項。 |

coresite.xml |

Hadoop核心配置文件,包含Hadoop集群的基本設置。 |

job.xml |

MapReduce作業配置文件,定義作業的各種參數。 |

mapper.py |

Python腳本,實現Mapper邏輯。 |

reducer.py |

Python腳本,實現Reducer邏輯。 |

setup.py |

可選腳本,用于在作業開始前設置環境或庫。 |

cleanup.py |

可選腳本,用于在作業結束后清理資源。 |

3. MapReduce源碼的關鍵部分

a. Mapper

import sys

def mapper():

for line in sys.stdin:

# 處理每一行輸入數據

words = line.strip().split()

for word in words:

# 輸出中間鍵值對

print(f"{word}t1")

if __name__ == "__main__":

mapper()

b. Reducer

import sys

def reducer():

current_word = None

current_count = 0

word = None

for line in sys.stdin:

# 解析中間鍵值對

word, count = line.strip().split('t', 1)

count = int(count)

if current_word == word:

current_count += count

else:

if current_word:

# 輸出結果

print(f"{current_word}t{current_count}")

current_word = word

current_count = count

# 輸出最后一個單詞的計數

if current_word == word:

print(f"{current_word}t{current_count}")

if __name__ == "__main__":

reducer()

4. MapReduce作業提交命令

hadoop jar /path/to/hadoopstreaming.jar n files mapper.py,reducer.py n input /path/to/input/data n output /path/to/output/directory n mapper mapper.py n reducer reducer.py

上述代碼示例是使用Python編寫的簡單MapReduce程序,實際的MapReduce源碼可能涉及更復雜的數據處理和并行計算邏輯,具體的MapReduce實現可能會有所不同,取決于所使用的編程語言和平臺。

聲明:所有內容來自互聯網搜索結果,不保證100%準確性,僅供參考。如若本站內容侵犯了原著者的合法權益,可聯系我們進行處理。